AIの「嘘」は、人間の嘘とちょっと違う?

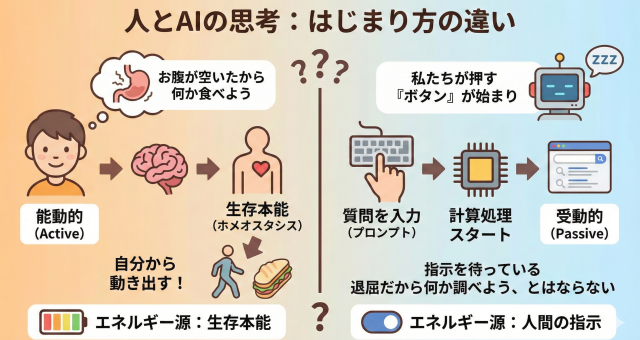

まず大切なのは、AIは人間のように「誰かを騙してやろう」という意図を持って嘘をつくわけではない、ということです。AIが生成する事実と異なる情報のことは、よく「ハルシネーション(幻覚)」と呼ばれます。まるで人間が幻を見ているかのように、もっともらしいけれど事実ではない情報を作り出してしまう現象です。

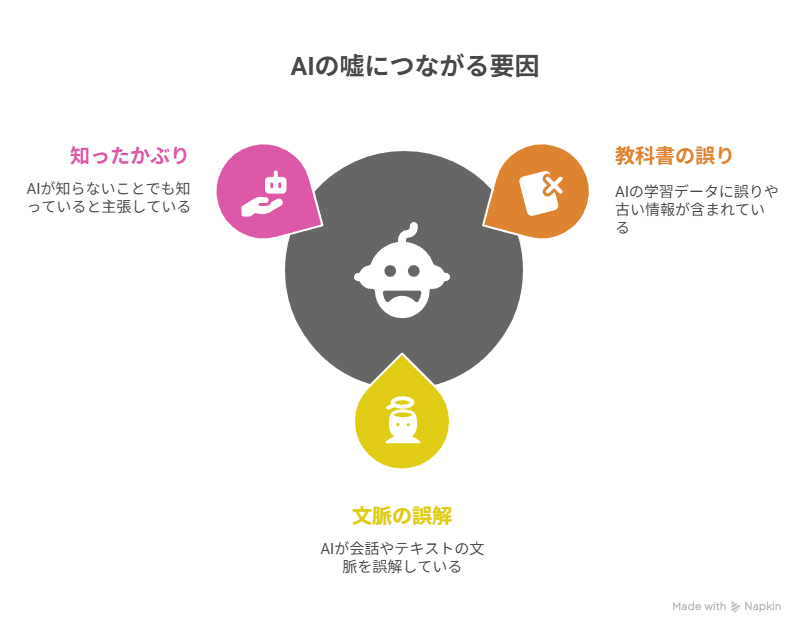

なぜAIは嘘をつく(ハルシネーションを起こす)の?

AIが嘘をついてしまう主な原因は、大きく分けて3つあります。

1. 教科書(学習データ)が間違っている・古い

AIは、インターネット上の膨大な文章や書籍などのデータを「教科書」として学習し、言葉のパターンを覚えます。しかし、その教科書自体に間違った情報や古い情報が含まれていると、AIはそれを正しいものとして覚えてしまい、間違った答えを生成してしまいます。

* 例: 去年変わった法律について質問しても、AIが古い法律の情報を元に答えてしまう。

2. 話の流れを勘違いしてしまう

AIは、単語と単語のつながりのパターンを学習して、「この言葉の次には、この言葉が来そうだ」と予測しながら文章を作っています。そのため、質問の本当の意図や文脈を正確に理解できないと、文法的には正しくても、意味が通らない、あるいは事実と異なる文章を作り出してしまうことがあります。

* 例: 「日本の首都で、美味しいラーメン屋は?」と聞いたつもりが、AIは「日本の首都」「美味しいラーメン屋」というキーワードだけに反応し、大阪の有名なラーメン屋を答えてしまう。

3. 知らないことでも「知ったかぶり」してしまう

AIは、質問に対して何か答えることを優先するように作られています。そのため、知らないことや自信がないことでも、「分かりません」と答える代わりに、学習した知識の断片をもっともらしくつなぎ合わせて、自信満々に答えてしまうことがあります。これが、最も厄介な「嘘」の原因です。

* 例: 実在しない歴史上の人物の逸話を、さも事実であるかのように語ってしまう。

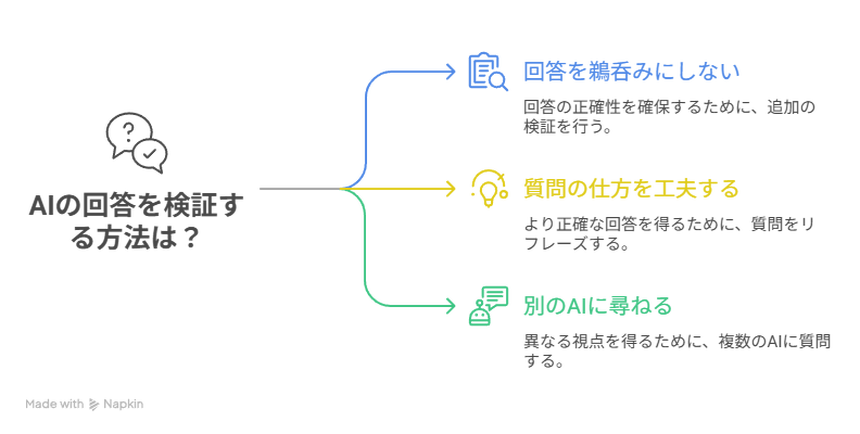

AIの嘘への対策法

では、どうすればAIの嘘に騙されず、上手に付き合っていけるのでしょうか。

【自分でできる対策】

一番大切なのは「AIの答えは、必ずしも正しくない」と常に心に留めておくことです。

答えを鵜呑みにしない(ウラを取る)

- AIの答えはあくまで「下書き」や「ヒント」と考え、特に重要な情報(仕事、健康、お金など)については、必ず公式サイトや信頼できるニュースサイトなど、別の情報源で確認しましょう。お医者さんにセカンドオピニオンを求めるのと同じ感覚です。

質問の仕方を工夫する

- 具体的に聞く: 曖昧な質問ではなく、「いつ」「どこで」「誰が」などを明確にして質問すると、AIが文脈を理解しやすくなります。

- 情報源を尋ねる: 「その情報の根拠は何ですか?」「どのウェブサイトを参考にしましたか?」と聞いてみましょう。答えてくれない場合や、おかしな情報源を挙げた場合は、その答えは怪しいと判断できます。

同じ質問を別のAIにも尋ねてみる

- 同じ質問を違うAIにしてその答えを比較検討することも大事です。

まとめ

AIの「嘘」は、悪意から生まれるものではなく、その仕組み上の弱点によるものです。AIは非常に便利な道具ですが、万能ではありません。

AIを賢く使う秘訣は、その答えを疑い、自分で確認する習慣を持つことです。 このポイントさえ押さえておけば、AIに振り回されることなく、その能力を最大限に活用できるでしょう。