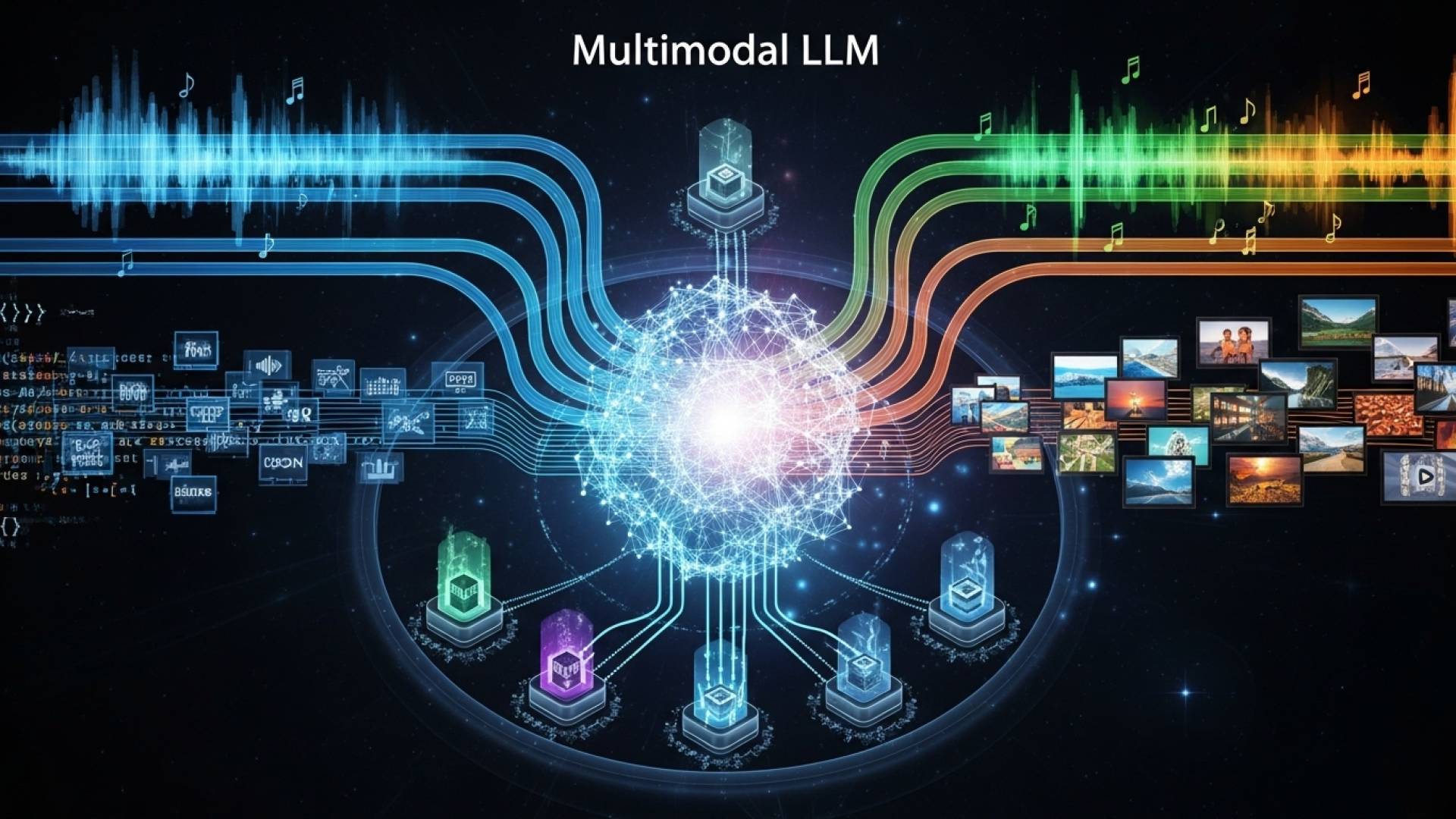

初期段階のAIは文字を処理することが基本でしたが、それらの進歩に伴い様々なデータを扱うことができるようになりました。現在、ChatGPTやGeminiなどのメジャーな大規模な言語処理モデル(LLM)においても、そういった機能が追加され、画像や音声なども処理できる状況になってきました。この章ではそういったLLMについて学んで行きます。

いろんな情報を理解できるAI「マルチモーダルLLM」ってなに?

一言でいうと、マルチモーダルLLM(Multimodal LLM)は「文字だけでなく、画像や音声も理解できる、とても賢いAI」のことです。

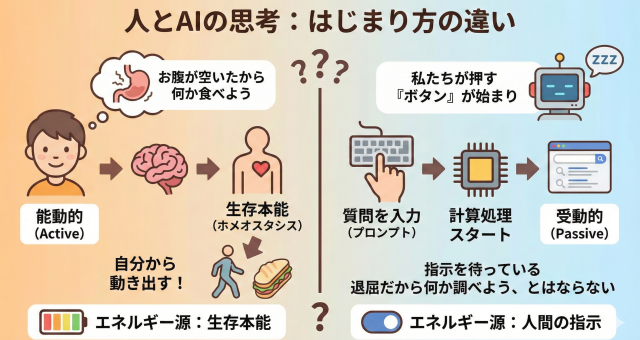

人間が目で見たり(画像)、耳で聞いたり(音声)、文字を読んだりして、物事を総合的に理解するのに似ています。このAIは、それと同じようなことをコンピューター上で実現しようとしています。

従来のAIとの違い

これまでのAI(特に「LLM」や「大規模言語モデル」と呼ばれるもの)は、主に文字(テキスト)の専門家でした。文章を要約したり、質問に答えたり、小説を書いたりと、言葉に関することは非常に得意でした。

しかし、マルチモーダルLLMはそれに加えて、画像や音声といった、文字以外の情報も一緒に理解できるのが大きな特徴です。

例えば、こんなことができます!

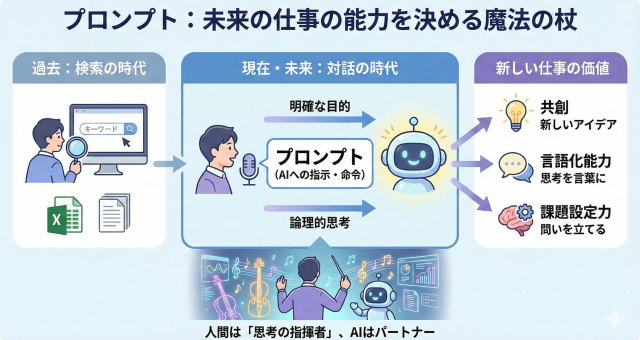

マルチモーダルLLMを使うと、人間とコミュニケーションをとるように、AIに様々なことをお願いできます。

- 写真を見せて質問する

冷蔵庫の中の写真を撮って「この食材で何が作れる?」と聞くと、AIが写真の中の野菜やお肉を認識して、レシピを提案してくれます。 - 音声でお願いする

会議の録音データをAIに聞かせて「この会議の要点をまとめて」と頼むと、話の内容を理解して議事録を作成してくれます。 - 画像と文字で指示する

スマートフォンの画面のスクリーンショットを見せて、「このボタンは何の機能?」と文字で質問すると、AIが画像と質問文の両方から意味を読み取って、「それは設定画面を開くボタンです」と教えてくれます。

どうやって実現しているの?

とても簡単なイメージで言うと、AIは画像や音声といった様々なデータを、一度自分たちが理解できる「共通の言葉」のようなものに翻訳しています。

全ての情報をこの「共通の言葉」に置き換えることで、AIは「この画像」と「この言葉」がどう関係しているのかを理解し、私たちの質問に的確に答えられるようになります。

代表的なサービス

- OpenAI ChatGPT (GPT-4o)

概要:OpenAIによるマルチモーダルAI。テキスト・画像・音声・コード処理などを統合。リアルタイム会話にも対応。

公式URL:https://chat.openai.com/ - Google Gemini

概要:Google製マルチモーダルAI。テキスト・画像・音声・コード・データ解析に対応し、Android版ではカメラ入力も可能。

公式URL:https://gemini.google.com/ - Anthropic Claude 4

概要:PDFや画像の読み取りに対応したマルチモーダルAI。自然言語理解・倫理的対話設計に強み。

公式URL:https://claude.ai/ - 4. xAI Grok

概要:Elon Musk率いるxAI社によるAI。X(旧Twitter)と統合され、SNS文脈を踏まえた会話・情報検索が得意。Grok-3では「Aurora」という画像生成ツールが搭載されており、テキスト指示に基づいて高品質な画像を生成することも可能。

公式URL:https://x.ai/(※Grokは https://twitter.com でも統合提供)