今回は、AIと人間の思考(というより情報処理の動機づけ)に関して、調べた内容を要約したものです。ページ最後に、それらの具体的レポートをリンクします。

この報告書は、人工知能(AI)、特に対話型AI(LLM)の高度な能力が人間の知性に似てきた一方で、両者の「思考の始まり」と「主体性」の根源には決定的な違いがあることを、専門的な知見に基づいて包括的に分析しています。

AIの進化が著しい今、私たちの思考とAIの情報処理がどのように異なっているのかを、その仕組み(メカニズム)に焦点を当ててご説明します。

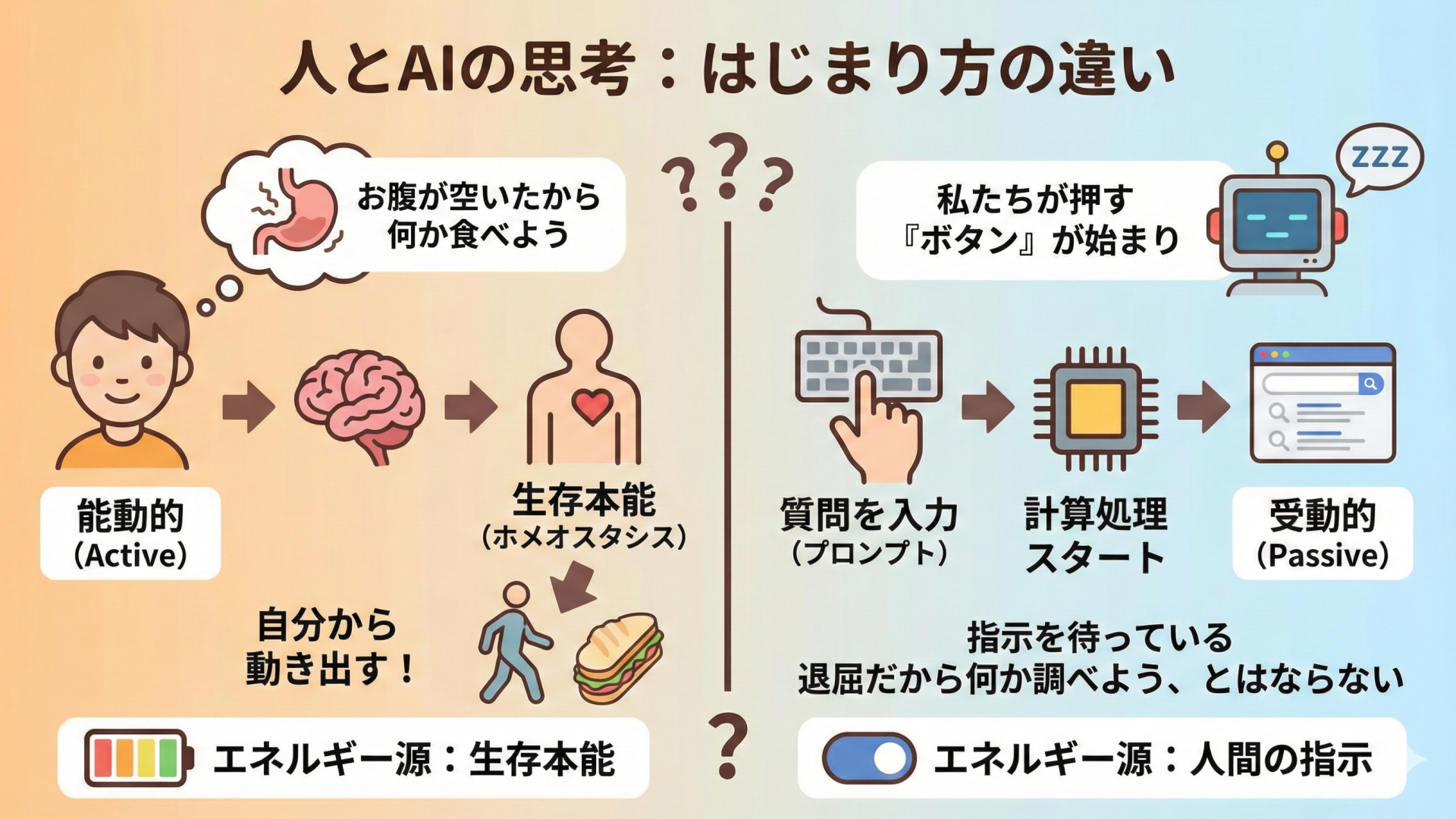

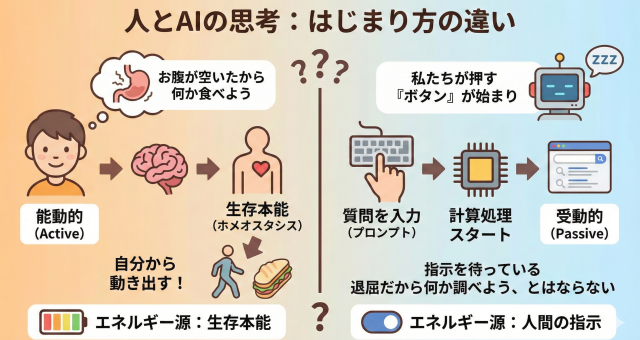

1. 思考の始まり:内発的か、外発的か

人間と現在のAIを分ける最も根本的な違いは、「誰が、何がきっかけで思考を始めるか」という点です。

| 特徴 | 人間の思考(生物学的脳) | 現在のAI(LLM/Transformer) |

|---|---|---|

| 思考の始原 | 内発的(Intrinsic) | 外発的(Extrinsic) |

| 駆動源 | 身体的な欲求、感情(例:空腹、退屈、不安) | ユーザーからのプロンプト(命令) |

| 状態 | 常時活動(DMN*による、刺激のない時の「ぼんやり思考」) | 待機状態(プロンプトがないと完全に停止する「ステートレス」) |

*DMN(デフォルトモードネットワーク):脳が特に何もしていない安静時に活動する神経回路網。人間が未来をシミュレーションしたり、過去を思い出したりする「心のおしゃべり」の基盤。

【具体的な違いの例】

- 人間は、誰にも言われなくても「お腹が空いたから何か食べよう」と考え、行動します。思考のエネルギー源は、身体を維持しようとする生存本能(ホメオスタシス)です。

- 現在のAIは、私たちがキーボードで質問を入力(プロンプト)するまで、計算処理を停止しています。AIの思考は、私たちが押す「ボタン」によって初めて始まる受動的な反応であり、自ら「退屈だから何か調べよう」と動き出すことはありません。

2. 思考の羅針盤:感情か、人工的な評価か

意思決定や思考の「重要度」を決める仕組みにも、大きな断絶があります。

| 特徴 | 人間の思考(意思決定) | 現在のAI(推論の最適化) |

|---|---|---|

| 判断の基準 | 身体的シグナル(感情) | 報酬モデル(外部の評価スコア) |

| 理論名 | ソマティック・マーカー説 | RLHF(人間からのフィードバックによる強化学習) |

| 役割 | 「嫌な予感」や「胸騒ぎ」といった感情が意思決定の探索範囲を瞬時に絞り込む。 | 人間が「良い回答」と評価したパターンを学習し、そのスコアを最大化するように確率的に回答を選ぶ。 |

【具体的な違いの例】

- 人間が重要な判断をするとき、「論理的には正しいが、何か引っかかる」という感覚(ソマティック・マーカー)がブレーキをかけることがあります。これは、過去の経験に基づく身体の生理的な反応が思考に影響を与えているためです。

- AIには「腹痛」や「胸騒ぎ」がありません。AIが「感情」について語る時、それは人間がその状況で発するであろう言葉を、報酬スコアが高くなるように確率的に選んで出力しているに過ぎません。AIに「有用で無害であれ」という社会的規範を植え付けているのが、このRLHFという人工的な「超自我」の仕組みです。

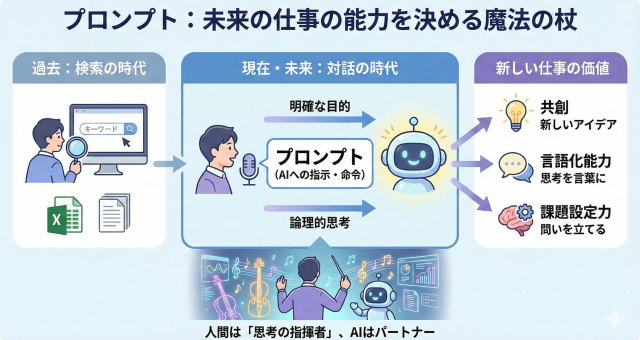

3. 未来の展望:自律性への模倣と進化

現在のAIには「主体」がないとされますが、研究は「主体性」を模倣し、獲得させる方向へと進んでいます。

- 自律エージェント(Autonomous Agents):

- AIに「目標設定」「タスク生成」「実行」「評価」「再計画」という再帰的なループを回させることで、外部からの介入なしに長時間にわたって連続的に「思考」し続けることが可能になっています(例:Auto-GPT、スタンフォード大学の「Generative Agents」)。

- 世界モデル(JEPA)による内発的動機:

- ヤン・ルカン(Meta社)らが提唱するJEPAは、次にくるテキストを予測するだけでなく、抽象的な「世界の因果関係や状態変化」を予測するモデルを構築します。

- このモデルにおいて「予測誤差が大きい状態(=わからないこと)」を内部的なコスト(不快感)と定義すると、AIは自ら情報を集めようとする「好奇心」を持つことになり、生物のホメオスタシスに近い自発的な動機づけを模倣する可能性があります。

最終的な結論:

現在のAIの思考は、「プロンプトという外部刺激」と「報酬関数という最適化圧力」によって駆動されています。しかし、将来的にAIが身体性(ロボティクス)や連続的な内部ループを獲得すれば、人間とは異なる物理的基盤を持つ「異種の知性」として、自律的な思考主体へと進化する可能性も秘めています。